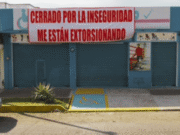

En la actualidad, la Seguridad Nacional entendida como la condición indispensable para garantizar la integridad y la soberanía nacionales, se ve directamente amenazada por el desarrollo y uso de la Inteligencia Artificial. Esta tecnología redefine el concepto mismo de amenaza al incorporar riesgos como ciberataques, manipulación masiva de información y vulneraciones a infraestructuras críticas, que pueden comprometer la soberanía nacional.

La seguridad nacional ya no depende únicamente de la defensa frente a amenazas externas, sino también de la capacidad de proyectar legitimidad y generar confianza en el ciberespacio, un entorno que, por su naturaleza global e interconectada, exige repensar las estrategias tradicionales de poder y protección. Por ende, la capacidad del Estado para proteger su soberanía y a sus ciudadanos también abarca el ámbito digital, donde la información y la conectividad son considerados recursos estratégicos.

La seguridad nacional ya no depende únicamente de la defensa física, sino también de la protección de activos digitales y medidas de defensa contra ciberataques y guerras informáticas. Debido a que el ciberespacio carece de fronteras tradicionales, los ataques pueden originarse desde cualquier lugar y afectar infraestructuras críticas. La ciberseguridad se convierte en un componente esencial que exige respuestas anticipadas a las amenazas cibernéticas mediante estrategias especializadas y políticas de resiliencia implementadas.

Hablar de inteligencia artificial sin considerar el marco legal del ciberespacio es omitir uno de los pilares fundamentales para su uso responsable. La regulación en esta materia es crucial para garantizar un entorno digital seguro. No obstante, la realidad es que la tecnología avanza a una velocidad mucho mayor que la capacidad del legislador para normarla.

En México existen disposiciones dispersas que abordan algunos aspectos relacionados, desde la protección de datos personales hasta ciertos temas de ciberseguridad, pero seguimos sin contar con una legislación especializada sobre inteligencia artificial o el ciberespacio específicamente.

Nuestra Constitución, en su artículo 6°, reconoce el derecho al acceso a las tecnologías de la información y la comunicación como una garantía fundamental. A su vez, la Ley Federal de Protección de Datos Personales en Posesión de los Particulares establece lineamientos claros para el tratamiento de datos, imponiendo obligaciones a quienes los manejan en cuanto al consentimiento y la seguridad.

Por su parte, la Ley Federal de Telecomunicaciones y Radiodifusión promueve la competencia y el acceso en el entorno digital. La Ley de Seguridad Nacional plantea principios generales para la defensa de la soberanía, pero no contempla expresamente la ciberseguridad; apenas en su artículo 5° se mencionan amenazas que podrían incluir ataques cibernéticos, aunque de forma ambigua.

En materia penal, el Código Penal Federal tipifica diversos delitos informáticos, como el acceso no autorizado a sistemas informáticos, pero resulta alarmante que términos como “ciberespacio” o “digital” ni siquiera aparezca en la redacción de los tipos penales. Desde una perspectiva penalista, esta omisión no solo exhibe lo lejano que está el legislador de estos temas contemporáneos, sino que revela también un desfase evidente entre el avance tecnológico y la forma en que se construye el tipo penal en México. En un entorno donde la mayoría de las interacciones humanas y delictivas comienzan a migrar al plano digital, no reconocer jurídicamente al ciberespacio como un ámbito específico equivale a legislar con los ojos cerrados ante la realidad actual.

Este tipo de vacíos conceptuales no son solo una cuestión teórica; sino que tienen implicaciones prácticas graves. Complican la interpretación, obstaculizan la persecución penal y generan incertidumbre tanto para operadores jurídicos como para la ciudadanía. Somos conscientes de que no se trata simplemente de actualizar términos, sino de entender que el ciberespacio es hoy un entorno autónomo, con lógicas propias y que el derecho penal debe abordarlo con una estructura normativa a su altura. Si no damos ese paso, seguiremos enfrentando delitos contemporáneos con herramientas del siglo pasado.

Uno de los casos más mediáticos y pioneros en América Latina y México fue el del exalumno del IPN, Diego “N”, quien se convirtió en la primera persona detenida en la región en un caso penal en el que intervino esta tecnología como medio comisivo del delito. Fue acusado de alterar con algoritmos de generación automatizada miles de imágenes de sus compañeras para simular desnudos y comercializarlas como contenido sexual. Este caso visibilizó los vacíos legales en torno a la violencia digital y la manipulación de imágenes mediante sistemas inteligentes.

Otros ejemplos palpables son el caso del ataque a la Comisión Nacional del Agua en 2023, así como el hackeo a la Secretaría de la Defensa Nacional (SEDENA) donde se expuso información altamente confidencial de carácter militar y sensible.

Conscientes de estas limitaciones, han existido iniciativas de ley orientadas a modernizar el marco jurídico, sin que ninguna de ellas fuera aprobada. Entre ellas destacan la Ley Federal de Ciberseguridad, propuesta en 2023 y la Ley Nacional de Seguridad en el Ciberespacio, presentada en 2020.

Contar con leyes en materia de ciberseguridad es imprescindible para dar atribuciones jurídicas a la entidad encargada de la ciberseguridad en el país y dar certidumbre jurídica a ciudadanos y autoridades para la atención de los delitos cibernéticos.

La INTERPOL asume un rol clave en la adopción y regulación de la inteligencia artificial para fortalecer la cooperación policial internacional. Con el apoyo de la Unión Europea y el Instituto Interregional de las Naciones Unidas para Investigaciones sobre la Delincuencia y la Justicia (UNICRI), desarrolló el Manual para una innovación responsable en IA y el Toolkit for Responsible AI Innovation in Law Enforcement, que ofrecen pautas éticas y técnicas para implementar IA en cuerpos de seguridad sin vulnerar derechos humanos.

La INTERPOL también alertó sobre el uso de IA por el crimen organizado, percibiendo esta tecnología como una herramienta estratégica y un frente de riesgo, donde la cooperación internacional y la ética tecnológica son claves para enfrentar el crimen transnacional.

Así, en el Estado Mexicano pueden vislumbrarse tres principales escenarios relacionados con la implementación de inteligencia artificial en la materia penal: i) su uso como medio para cometer delitos, ii) su aplicación como herramienta de prevención del delito y iii) su incorporación en procesos de individualización y determinación de responsabilidades penales.

Respecto al primer escenario, la IA es ya un poderoso recurso para la comisión de actos delictivos, especialmente en el terreno de la ciberdelincuencia. Ante este fenómeno, surge la necesidad urgente de adecuar el marco jurídico a las nuevas formas delictivas que emergen con el uso de estas tecnologías, pues su falta de regulación puede derivar en zonas de impunidad. Un ejemplo ilustrativo es el de los deepfakes , que pueden vulnerar derechos fundamentales como la imagen, el honor, la intimidad, el libre desarrollo de la personalidad e incluso la libertad sexual.

De igual forma puede emplearse para el desarrollo e implementación de estrategias bélicas mediante algoritmos sofisticados y drones que pueden, o no, requerir el control humano.

Se vuelve entonces imprescindible abordar el tema de la responsabilidad jurídica derivada del uso de la IA. Hoy en día es evidente que puede causar daños a bienes jurídicos protegidos actuando con cierto grado de autonomía. Esto plantea un problema jurídico relevante: si no es posible atribuir responsabilidad penal a la máquina, ¿quién debe responder? La legislación tradicional ofrece dos posibilidades: el fabricante y el programador.

En cuanto al uso de la IA como instrumento de prevención del delito, se han identificado ventajas significativas en el combate a la criminalidad mediante su eventual implementación en análisis de video, detección de actividades sospechosas y ciberseguridad para detectar y responder posibles amenazas. Sin embargo, también se advierte el riesgo de que estas herramientas, si se utilizan de forma desproporcionada o sin supervisión adecuada, vulneren derechos fundamentales. Es imprescindible establecer regulaciones claras que aseguren la protección de la privacidad, la intimidad y el derecho a la autodeterminación informativa, así como garantizar siempre el control humano sobre estas tecnologías.

En lo que respecta a la IA como apoyo en la individualización y atribución de responsabilidad penal, ya existe en Norteamérica sistemas capaces de generar predicciones que podrían influir en las decisiones judiciales. No obstante, dichos sistemas mostraron estar sesgados ya que los datos que los alimentan contienen estereotipos o prejuicios sociales y raciales por lo que debe evitarse que estos sistemas se conviertan en el único criterio para resolver casos, especialmente si valoran únicamente el historial delictivo de una persona en lugar de analizar la conducta específica desplegada.

La rápida evolución del machine learning y otras técnicas de inteligencia artificial llevan a proponer el reconocimiento de una nueva categoría jurídica: la persona artificial.

A diferencia de la persona física o la persona jurídica, esta figura estaría destinada a representar jurídicamente a sistemas de IA capaces de aprender, tomar decisiones y ejecutar acciones de forma autónoma. Esta capacidad de actuar sin intervención humana directa abre la posibilidad de que la IA no solo sea una herramienta, sino un verdadero sujeto activo del delito, especialmente en el ámbito de los ciberdelitos, donde su precisión técnica y capacidad de ocultar rastros la hacen potencialmente más peligrosa que el ser humano.

La creación de la persona artificial parte de tres ideas fundamentales. En primer lugar, el nivel de autonomía que pueden alcanzar ciertas IA particularmente las que utilizan aprendizaje automático y profundo, les permite realizar conductas típicas de delitos informáticos con gran efectividad. En segundo lugar, la regulación actual no ofrece una vía directa para atribuir responsabilidad penal cuando la conducta ha sido ejecutada por una entidad tecnológica independiente. Y, en tercer lugar, la ausencia de precedentes regulatorios deja un vacío que podría volverse crítico a medida que la IA se integre más en la vida cotidiana.

Para materializar esta idea, se propone actuar en dos niveles. El primero sería reconocer la personalidad artificial en el ámbito constitucional y civil, incorporando conceptos como identidad jurídica electrónica, persona artificial e identidad artificial.

El segundo consistiría en crear reglas de responsabilidad penal específicas para esta categoría, tomando como referencia las particularidades que el derecho ya reconoce para ciertos grupos, pero adaptadas a los riesgos propios del ciberespacio.

Esta síntesis del marco jurídico se plantea como un paso necesario para enfrentar conductas ilícitas cometidas por IA que no puedan ser imputadas directamente a una persona física.

Uno de los argumentos que refuerza la viabilidad de esta propuesta es que el sistema mexicano ya contempla la responsabilidad penal de personas morales en el artículo 11 del Código Penal Federal. De manera análoga, una IA podría ser sujeta de responsabilidad penal, y las sanciones previstas para las personas jurídicas podrían adaptarse para aplicarse a una persona artificial. Entre las conductas que podrían imputarse a esta figura se encuentran el terrorismo, el fraude, la falsificación documental, el acceso ilícito a sistemas y otros delitos propios del entorno digital.

El reconocimiento de esta figura no implicaría descontextualizar negativamente la tecnología. La propuesta incluye también medidas para fomentar el uso responsable de la IA, aprovechando su potencial como herramienta en la investigación criminal, la prevención del delito y la administración de justicia.

El futuro de la inteligencia artificial es incierto, pero lleno de posibilidades. Una de sus metas más ambiciosas es el desarrollo de la Inteligencia Artificial General (IAG), una forma avanzada de IA que podría aprender, adaptarse y resolver problemas en distintos contextos, superando incluso la capacidad humana. No obstante, su creación plantea importantes retos en términos de seguridad, control y alineación con los valores humanos.

La Unión Europea nos da la pauta al haber adoptado una postura clara frente al avance de la inteligencia artificial al no enfocarse en liderar la carrera tecnológica global como creadora o impulsora principal de estos desarrollos, en su lugar optó por asumir un rol regulador, priorizando la protección de los derechos fundamentales, la seguridad y la ética.

A través de iniciativas como la Ley de Inteligencia Artificial (AI Act), busca establecer un marco jurídico robusto que limite los riesgos y garantice que el uso de esta tecnología sea transparente, responsable y alineado con los valores democráticos del continente; esto debería adoptarse de manera global.

México, en este sentido, debe observar con atención esta postura europea y adaptarla a su propia realidad. Frente al crecimiento inevitable de la IA, el Estado Mexicano no puede permanecer pasivo ni limitarse a ser consumidor de tecnología extranjera sin cuestionar su impacto, sería un error fatal.

Como podemos observar, México enfrenta una situación crítica en materia de inteligencia toda vez que actualmente no contamos con una regulación integral ni con una estrategia nacional que articule esfuerzos, establezca prioridades y garantice un uso ético, seguro y eficaz de estas herramientas. Aunque, como advertimos antes, en nuestro marco legal existen disposiciones sobre protección de datos, derechos de autor y no discriminación, lo cierto es que ninguna aborda de manera específica y sistémica los desafíos que plantea esta tecnología.

La innovación tecnológica y en particular la inteligencia artificial, no garantiza por sí misma un verdadero progreso social. Una IA desarrollada y controlada únicamente por unos pocos actores concentra el poder y amplía las brechas existentes, favoreciendo intereses privados por encima del bienestar colectivo. Hoy nos beneficia solo a unos pocos.

Para que la innovación se traduzca en beneficios reales, las IA deben ser accesibles, comprensibles y utilizables por toda la sociedad, no solo por corporaciones o gobiernos. Democratizar el acceso a estas herramientas no significa renunciar a la seguridad o la ética, sino asegurar que su potencial se oriente hacia soluciones que mejoren la vida de las personas, reduzcan desigualdades y fomenten una participación más equitativa en el desarrollo tecnológico.

Una regulación bien diseñada no frena la innovación, sino que establece un marco de confianza donde ésta puede desarrollarse de forma responsable y con beneficios reales para la sociedad.

No se trata solo de lo que la IA puede hacer por nosotros, sino de lo que el país está dispuesto a hacer para que la IA esté al servicio del bien común. Ese debe ser nuestro compromiso y esa nuestra responsabilidad, una responsabilidad compartida.

Cierro mi participación recordando a nuestro homenajeado, el jurista mexicano Héctor González Uribe, quien, por allá de 1992, en su libro Teoría Política, nos dio una definición de Estado que trascendió en los años.

Su definición revela la tinta visionaria del Maestro González Uribe, pues hoy, más que nunca, su idea del Estado nos sirve como punto de partida para reflexionar sobre las prospectivas y los retos que enfrenta y enfrentará México ante la irrupción de la inteligencia artificial.

Regular la inteligencia artificial no es un ejercicio técnico aislado; es una decisión sobre el tipo de sociedad que queremos construir. El Derecho debe ser el instrumento que garantice que esta tecnología sirva a la justicia, preserve la dignidad y fortalezca la libertad.

Muchas gracias por su atención.