Por Viviana García y Mathias Spielvogel

El pasado 5 de noviembre se publicó una modificación al Código de Protección y Defensa del Consumidor del Perú (Ley No. 31601) mediante la cual se dispone que los consumidores tienen derecho a una atención personal cuando el proveedor ofrezca al público cualquier sistema de atención automatizada asistida por inteligencia artificial o asistencia digital. Atención personal o humana versus atención mediante un sistema alimentado por inteligencia artificial. Ese debate que a veces surge coloquialmente en nuestras conversaciones sobre los errores que tienen los sistemas que nos atienden, sobre las largas esperas que como consumidores asumimos cuando queremos hacer algún reclamo, ha sido de alguna manera plasmado en esta norma. En este caso la ley ha establecido que el proveedor debe permitir al consumidor realizar esta elección.

Desde un inicio la inteligencia artificial ha sido un campo de estudio y de práctica polémico, su integración se ha planteado como la respuesta a muchos de nuestros problemas, o quizás en opinión de algunos como el conducto hacia un futuro distópico orwelliano o ciberpunk. En efecto, para quienes hemos leído la novela “1984” de George Owell, nos sorprende que en los años 1947 y 1948 el autor se imaginara un mundo donde un gran hermano estaba omnipresente, nuestro lenguaje podía reducirse a una neolengua y, en breve, donde se intentaba controlar o anticipar nuestros pensamientos. Y es que hoy en día dicha novela de ficción bien podría describir el estado de hipervigilancia que vivimos, la brevedad de nuestras nuevas formas de comunicarnos usando redes sociales y emoticones y, ciertamente, la presencia de leyes que se pronuncian sobre el efecto de los algoritmos en nuestras vidas.

Pero, brevemente, ¿de qué trata la inteligencia artificial? La inteligencia artificial es un área de investigación que se ubica dentro de las ciencias de la computación o de la ingeniería informática mediante el cual se enseña a las máquinas a emular la inteligencia humana para realizar tareas de forma más rápida o eficiente. Esto se realiza a través de un proceso llamado aprendizaje automático. Dentro de este subcampo de la informática, se construyen algoritmos para obtener resultados basados en la recopilación de ejemplos de la fenomenología que se está estudiando. Los ejemplos que permiten alimentar a las máquinas pueden ser: elegidos a mano por seres humanos, ejemplos representativos de estructuras existentes en la naturaleza o, en algunos casos, ser puntos de datos generados por otro algoritmo. A su vez, estos modelos de aprendizaje automático pueden ser deterministas o probabilísticos, dependiendo de su función, complejidad y tarea. Por tanto, lo que es el campo del aprendizaje automático abarca la recogida de datos, el almacenamiento, el preprocesamiento, las pruebas y el mantenimiento posterior de todos los puntos de datos y el resultado.

Lo cierto es que la inteligencia artificial y el aprendizaje automático no son el futuro dado que son parte de nuestra cotidianeidad, actuando sobre nuestros teléfonos, plataformas de streaming, servicios de asistencia sanitaria, sistemas de transporte público, sistemas de asistencia automática e incluso nuestros automóviles.

Si bien conceptualizar la inteligencia artificial y todo lo que ello implica no es sencillo, la verdadera complejidad viene dada cuando se trata de la aplicación de esta. ¿Puede la inteligencia artificial aplicarse en el campo de la política, o incluso en el campo de la justicia penal? ¿Podemos confiar todo tipo de tareas o decisiones que requieren ser concluidas con rapidez y eficiencia a las máquinas que, como indicamos, se han alimentado al fin y al cabo de nosotros mismos, la fenomenología y la estadística?

Ya en el junio del año 2015 Walter Frick nos indicaba en su artículo “When your boss wears metal pants” publicado en la revista Harvard Business Review que el primer reto que debemos enfrentar en lo que respecta a trabajar con “máquinas que piensan” es reconocer que en la mayoría de las veces saben más que nosotros. Ello determina que se genere en nosotros un fenómeno llamado “evitar el algoritmo”. Esto es, las personas preferimos el juicio del ser humano, nuestro juicio o el de otra persona, que el de una máquina. Consideramos que el juicio humano puede mejorar o evolucionar, más no le damos ese acto de fe a las máquinas. Otro de los retos que se enfrentan es cómo lucen estas máquinas y allí es donde aparece la tendencia al antropomorfismo, la idea de atribuir forma o cualidades humanas a lo que no lo es. Según Frick, varios estudios sugieren que darle a la máquina una voz, un cuerpo y hasta un nombre permitiría que las personas se sientan en confianza y, por tanto, puedan trabajar y colaborar. Sin embargo, ello nos lleva a preguntarnos, ¿qué tan humanas deberían lucir las máquinas? ¿Será que, si las máquinas se asemejan más al ser humano, podríamos esperar más de ellas en comparación con las que no han adoptado esa forma?

Ahora bien, más allá de estas dificultades, cuando nos enfrentamos a los sistemas de administración de justicia, una de las principales preocupaciones que surgen es si la inteligencia artificial puede contribuir a la tan buscada equidad. Entonces, ¿si nuestros sistemas de administración de justicia carecen de imparcialidad y probidad, será que la inteligencia artificial puede marcar una diferencia?

La necesidad de una inteligencia artificial encaminada a esta equidad es innegable. Efectivamente, observando las estadísticas de grupos raciales o étnicamente desfavorecidos en prisión o en detención preventiva dentro de los Estados Unidos de América y, comparando esas cifras con la distribución de los grupos étnicos existentes dentro de ese grupo demográfico, es claro que existen impactos dispares de discriminación dentro de los actuales modelos de «inteligencia humana». ¿Si ello sucede, puede ello replicarse cuando estamos ante la inteligencia artificial?

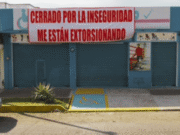

Según «Automating Injustice 2021», informe elaborado por Fair Trials, un grupo de derechos civiles financiado por la Unión Europea, los datos utilizados para entrenar este tipo de algoritmos vinculados a la administración de justicia consisten enteramente en datos proporcionados por las entidades que actualmente aplican las leyes. Es por esta razón que existen muchas interrogantes en cuanto a la propagación de los defectos que existen dentro de los diferentes sistemas de justicia penal que son culpables de la discriminación racial y étnica. Además, son estas válidas preocupaciones las que podrían conducir a estos sistemas inteligentes a una violación de derechos fundamentales como el derecho a un juicio justo, la protección de datos y, lo más obvio, la privacidad. Y si se trata de sistemas que actúan de manera más rápida, ¿estaremos ante la posibilidad de incrementar exponencialmente esta falta de equidad en los sistemas de administración de justicia?

Como mencionáramos al inicio de esta nota, no cabe duda que la inteligencia artificial ya se aplica en las decisiones que hacemos como consumidores, en los lugares de trabajo al decidir a quién se contrata y a quién se despide, analizando el currículum o utilizando métricas que representen la productividad esperada. Se utiliza en las universidades para decidir quién va a asistir a ellas, en los sistemas sanitarios para decidir quién es el más adecuado para un trasplante de órganos y en los gobiernos en situaciones bélicas para decidir dónde dirigir un ataque con un dron.

Un área de desarrollo interesante por sus posibles derivaciones y las consecuencias en los derechos fundamentales de las personales es, por ejemplo, el campo de la visión por ordenador que tiene su origen en el año 1999 con la integración del algoritmo denominado Scale-Invariant Feature Transform (SIFT) publicado y patentado por David Lowe. La implementación de la inteligencia artificial en el campo de la tecnología de detección de objetos comienza en el año 2012, con la Deep Convolutional Neural Network (DCNN) AlexNet diseñada por Alex Krizhevsky. Esta tecnología es la que ha dado lugar a los actuales progresos dentro del campo de la videovigilancia que incluyen: clasificación, detención de objetos, segmentación, estimación de la pose y, lo más importante, reconocimiento de acciones. ¿Podemos extrapolar la detección de objetos a la detección de acciones o conductas? En algunos sistemas de administración de justicia al parecer la respuesta es que si se puede. En efecto, la aplicación de estas nuevas tecnologías puede ya observarse en el denominado “Sistema 206”, una herramienta de inteligencia artificial instituida por el gobierno chino que permite ayudar a los fiscales a evaluar las pruebas e identificar casos de delitos como: fraude, conducción temeraria y robo. Sin embargo, como comentáramos previamente, esta herramienta sigue dependiendo en gran medida de la participación humana en el proceso de toma de decisiones ya que las máquinas carecen de la capacidad de procesamiento de lenguaje complejo tal como sucede en nuestras redes neuronales.

Mientras ello sucede y se experimentan los alcances de la inteligencia artificial en distintos campos, la Unión Europea tiene una preocupación válida sobre las posibles implicancias que se pueden dar a los derechos fundamentales de las personas y un caso claro son los sesgos de selección.

El sesgo de selección se produce cuando la elección de las fuentes de datos para alimentar los sistemas de inteligencia artificial se basa en la disponibilidad, la conveniencia o la rentabilidad. Un ejemplo que es ya conocido es el referido al software de reconocimiento facial de Apple, que no detecta a las personas de raza negra con la misma precisión que a otros grupos raciales introducidos en el proceso de aprendizaje automático. De hecho, muchos pioneros en el campo del reconocimiento facial como son las empresas Microsoft, IBM, Kairos y Amazon son responsables de los porcentajes más bajos de precisión de sus sistemas en el caso de mujeres de piel más oscura. Otros casos de sesgo incluyen el llamado “ruido”. Si las mediciones utilizadas para entrenar los sistemas de inteligencia artificial están constantemente sesgadas en una dirección, este direccionamiento es el que al final daña los datos de entrenamiento y, en última instancia, da lugar a un modelo de baja calidad y, por ende, con resultados deficientes. Y sin que los sesgos de raza o los ruidos sean suficientes, el propio sesgo del experimentador también está presente. Nos referimos a la tendencia a buscar, interpretar, favorecer, desfavorecer o recordar la información de una manera que afirme las creencias previas del propio experimentador. Además, el sesgo del experimentador puede producirse cuando el analista aporta información que apoya una determinada conclusión, de forma similar al sesgo de confirmación, que es la tendencia que tenemos de buscar información que respalde nuestras propias creencias.

Al iniciar esta nota comentábamos sobre una reciente norma relacionada al mundo del consumo y los usos de sistemas de inteligencia artificial. Desarrollamos también a lo largo de la misma que este es uno de los muchos campos de aplicación, existiendo algunos como es el caso de la administración de justicia que pueden afectar nuestros derechos fundamentales. Los legisladores deben conocer cada vez más de tecnología y ser cautelosos al regular las posibles implementaciones de la inteligencia artificial. Aunque muchos temores pueden ser infundados, la educación digital y la ciber-alfabetización pueden siempre contribuir a una comprensión más sana de los desarrollos que ya están en marcha y que seguirán impactando en nuestras vidas.

Viviana García

Graduada en Derecho en la Pontificia Universidad Católica del Perú (1999). Cuenta con una Maestría en Derecho Corporativo por New York University (2002), un Diplomado de Estudios Asiáticos, con mención en Estudios Chinos, en la Pontificia Universidad Católica del Perú y una certificación como Experta en Protección de Datos Personales por parte del Institut of Audit and IT Governance. En el año 2016, la Revista Latin Lawyer, la incluyó en su lista de “50 inspiring women practising Law in Latin America” y, en el año 2019, fue nominada por la publicación “Euromoney” dentro del grupo de abogadas “Best in Technology”. Ha obtenido certificaciones por HarvardX al completar el curso “Managing Risk in the Information Age”, así como también por Capacitación USACH – Universidad de Santiago de Chile como Implementador Líder ISO 29100 e Implementación de la Privacidad como DPO según el RGPD.

Luego de ser socia del área corporativa en firmas de abogados por más de 10 años, en el año 2020, fundó VG.pe, una empresa que brinda asesorías especializadas en privacidad y cumplimiento de la normativa de protección de datos personales. VG.pe plantea una nueva forma de brindar asesoría, principalmente en el entorno digital, acercando al cliente con el conocimiento del marco legal de una manera más intuitiva y, además, que le sea de utilidad de manera personal.

Mathias Spielvogel

Estudiante de último año de Derecho Internacional Comparativo en IE University (Madrid, España). Tiene experiencia en la investigación jurídica. Se esta especializando en Propiedad Intelectual, Derecho Cibernético y las nuevas tecnologías. Actualmente es practicante en la firma y Legal-tech, Evolvers Madrid. Anteriormente, fue practicante en el Parlamento de la República Federal de Alemania – el Bundestag.

Linkedln: Viviana García

Facebook: VGpe

Instagram: vgpeasesoria